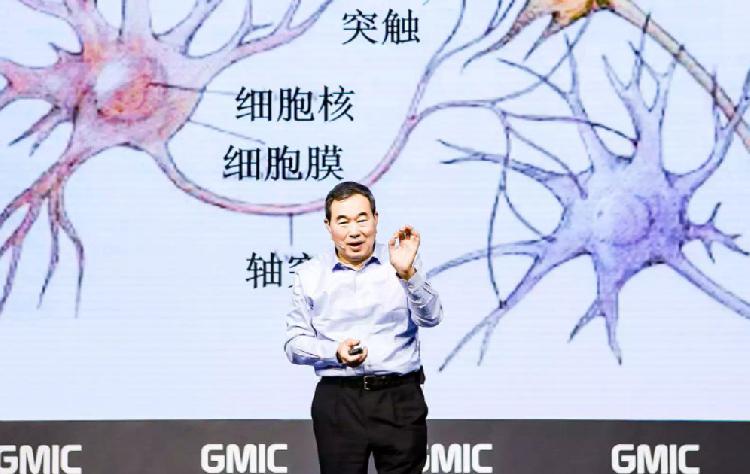

神经生物学家蒲慕明:脑科学将如何助力AI技术发展

2018 GMIC全球移动互联网大会昨日在北京开幕,本届大会主题为“AI生万物”。论坛上,神经生物学家、中科院神经科学研究所所长蒲慕明发表了演讲,阐述了脑科学的研究现状,以及如何助力人工智能和类脑智能的发展。

蒲慕明称,大脑最关键的是学习和记忆,学习和记忆也是人工网络关键的功能。人工网络在过去几十年来,最关键的一个从大脑,脑科学得到的启发,就是连接的可塑性。

“记忆的产生是靠神经之间的连接加强,通过同步的电活动。”蒲慕明解释称,现在研究的难点在于面孔识别的神经机制,比如你如何识别你祖母的面孔,是因为小时候祖母不断出现在你的视野里,她脸上每一个部位都激活一群神经元。超级细胞群在你祖母面孔出现的时候,就把这个超级的细胞群连在一起。这个集群让你看到祖母的眼睛,就可以想起她整个面孔,甚至是她的声音,因为我把整个集群记忆提取了。

蒲慕明解释称,现在新生结构,连接可以新生,可以消减,它可以减少能耗,增加效率,这个已经被证实了,它已经被我们中心的程序员在芯片上实现了。“什么信息需要遗忘,这也是需要解决的问题,什么样的信息需要长期保存,这个在人工智能方面也需要找到一个很好的算法。”

总之,脑科学与类脑人工智能的协同发展,相互支撑、相互促进、共同发展。(小羿)

以下为中科院神经科学研究所所长蒲慕明演讲实录:

蒲慕明:各位来宾,大家都知道人工智能现在是方兴未艾,可以做的事情很多,而且发展还有很大的前景。但是我们考虑未来的下一代人工智能,五年、十年、十五年之后,人工智能会需要更智能,首先需要知道我们目前的人工智能是专用的,不是通用的。我们现在最关键的技术,深度学习,机器学习的方法是大数据,高能耗,跟人脑比起来是差远了。所以怎么样从监督学习进入到非监督学习,像人脑一样,怎么像人脑那样有效率,我们应该从脑科学里得到一些启发。

我今天跟大家大部分是讲脑科学,但是最后会提到我讲的这些内容就可以代表将来科学如何能够对人工智能有所帮助。最重要的是包在大脑外面的皮层,这个皮层是人类特有,特别发达,在低等哺乳动物是没有的。但是内层的皮层也很重要,但是这个在进化上是保守的。我们知道这个复杂性来源于什么呢,重要的就是它的组成结构复杂,这个结构包含着大量的神经元,我说上千亿的神经细胞,我们神经元。不光数量多,种类也多,现在具体有多少种我们也还没有搞清楚。所形成的网络,在这个网络中长出这些凸起形成网络。在网络中有特殊的一些环路是进行各种功能的,所以整个网是连在一起的。但是种类多是一个很大的问题,不但它的形态多,形态不一样,功能也不一样,脉冲发送模式也不一样。所以要理解这个,就是知道在大脑,比如在动物系统里我们现在能做研究的,看它有多复杂。

说明这个复杂性我可以举这个例子,这个只有52个细胞皮层的神经细胞,我们把它连接再追踪出来,它所造成的网络结构是如此复杂,只有52个。想想我们人类大脑有千亿的神经细胞,它的连接是多么复杂。但是基本结构是很简单的,就是它一个细胞,细胞有一个细胞体,它长出很多凸起,这个凸起一边是输入,一边是输出。基本结构很简单,但是每个细胞种类性质不一样,所以是很复杂的。这跟人工网络大不相同。

大脑最关键的是学习和记忆,学习和记忆也是人工网络关键的功能。但是人的学习是怎么来的呢?我们感觉、运动、认知、行为,所有的都有电活动。这个电活动造成了我们神经系统网络结构的变化,包括功能的变化,神经元它自己的构造变化。还有图数,就是神经元连接的节点,这个节点就是记忆储存的地方。人工网络在过去几十年来,最关键的一个从大脑,脑科学得到的启发,就是连接的可塑性。功能可以变,而且结构也可以变,我们现在人工网络的结构大致上是不变,所以这是可以借鉴的地方。结果是一个新的网络产生之后,它就有新的认知行为的改变。

我们说这个结构怎么变呢,在几十年前有一个加拿大的科学家提出来了,网络的结构变了最好的一个方式,就是假如这个结构,这两个神经细胞它假如是同步放电,同样时间放电的话,把连接加强;假如放电时间不一样,它的连接可能减弱。他提出来这样一个假说。这个假说最后是简单的一句话,就是一起发放神经元连在一起,这是一个规则。这个规则也被哈佛用在他的人工网络里,他也开始把这个假说放进去,就是非常有用的人工网络可以做记忆学习。这个有实验证据,就是神经连接在高频刺激之后,它两个前后的细胞都有电活动,它就有增强;低频刺激之后,只有前面的这个细胞有活动,后面的细胞因为低频不能够激活,所以就弱,没有活动,所以就变成一个减弱。我想我们现在神经网络最大的功能就是感知,要知道外界的事情,要记忆,要学习。

赫伯还一个假说,就是把很多活动,把很多神经元连到一起,而且记忆就储存在他的记忆之中。假如提取记忆的话,就同样把机器学习细胞再激活,你就是记忆的提取。我们举个例子,比如在你的视野里有一个圆形,这个圆形激活了一大批细胞,每个细胞都是对圆形的曲线段有反映。这个细胞都是在圆形一起出现了激活,所以它的连接就加强了。所以得到了一个神经细胞的集群的连接的加强,加强以后,只要有部分信息来了,它就可以通过原来已经加强的连接就可以唤起整个记忆,圆形的记忆就出来了。所以说明记忆的产生,就是靠着这样把神经之间的连接加强,通过同步的电活动。

其实这个很有用的,现在的面孔怎么识别,比如怎么识别你祖母的面孔,因为你小时候你的祖母不断出现在你的视野里,她脸上每一个部位都激活一群神经元。现在这一个圈不代表一个神经元,是代表一圈,代表眼睛的一群,代表头发的一群,等等,这些全加到一起,这一都是一起被激活。所以超级的细胞群在你祖母面孔出现的时候,就把这个超级的细胞群连在一起。这个集群,实际上将来看到祖母的眼睛,我就可以想起她整个面孔,因为我把整个集群记忆提取了。这个集群我们说是千耗时集群,每个集群一部分是一个集群,所有的群加在一起又成了一个大群。这个大脑处理祖母信息,每个人都有不同的面孔记忆,他的记忆很可能就是这样产生的。这也变成了一个概念的记忆也可以这么来说,我们不光祖母的面孔,这是一个超级细胞群,这一圈就代表了一个超级细胞群。但是实际上还有跟祖母相关的细胞群,像她的声音等等都在这里。这个超级细胞群,就是祖母概率。你小时候听到祖母的面孔该想起她的声音。所以这就是我们现在在脑科学最好的假说,认知是怎么回事。当然这是一个假说,各种概念在脑区,概念把各个脑区的网络连到一起,然后让它产生强化。

这个跟怎么样产生网络,原来网络怎么出现了,我觉得脑科学里重要的一个,过去几十年最重要的一个进展,就是理解了人类大脑在发育过程中是怎么产生网络的。像婴儿出生一个月的时候没有什么网络,只有神经细胞。然后在两个月到最右边的两岁,他的网络大量生成。所以可以想像,网络生成的过程是干什么,就是小孩子一开始学习所有的能力,包括认知能力,包括对他的记忆,包括开始学语言,都在这个网络形成的过程中,所以跟我们人工网络不一样,人工网络是在那个地方,然后把大数据拿来学。但是知道的大脑网络是没有网络,是你信息不断的来,不断的形成新的,不断有新的网络产生,但是信息来的时候是把这个已经不断生成的网络有所修饰。

假如看到这个网络修饰的过程,产生的图数的数目,开始出生之后,是大量的上升的,上升之后要修剪,修剪是什么意思呢,就是学习,就是经验造成你大脑的结构。每个人的大脑都不一样,都有不一样的性格,想的不一样,记的事情不一样,因为在过去的一生你的经验不断修改你的大脑,围棋大师大脑跟我们普通人大脑不一样,因为他下了很多棋,已经对大脑经验进行了修改。我们常说人不需要大数据学习,一看到几个数据就知道怎么做决定了,因为他不需要这个大数据,他的大数据早已经在过去一辈子把他的网络修成了一个能够用小数据就把这个问题解决的。所以要一个真正有效的,未来人工网络必须要能够从网络形成的过程中来得到启发,来看我们怎么样用新的机器学习的算法。

我最后讲一下,我们自然神经网络有什么可以学的,我今天稍稍讲了一些。其实神经元网络有不同的亚型和功能,这样造成了它的复杂性,这个复杂性不止是有网络连接。还有我们人工网络的连接,都是正向的,往前运作的。也有一些逆向的连接也可以在用。侧向的连接,逆向的连接,其实在自然网络里非常复杂,而且是关键,就是各种不同种类的神经元,它是可以往回头送信息,也可以往前面送信息。最重要的是可以借鉴神经图数的可塑性。现在图数我们知道在功能上可塑,现在这是机器学习的方法,它是跟所需要的信息看有没有错误,有错误就调整上游的图数,这个是调整以后它的功能增强、减弱。但是我们现在已经知道调的方法是通过图数的频率可以变,频率代表高低频,代表他的网络节点前后细胞电活动的相关性。但是我们现在知道有跟时序相关的调法。还有刚才讲到结构是可以改变的,这个是非常重要的。

现在新生结构,连接可以新生,可以消减,它可以减少能耗,增加效率,这个已经被证实了,它已经被我们中心的程序员在芯片上实现了。还有可塑性可以有序的传播,还有逆向传播。还有网络图存,我们谈到效率和记忆的代表图存,假如消失了就是遗忘。什么信息需要遗忘,这也是需要解决的问题,什么样的信息需要长期保存,这个在人工智能方面也需要找到一个很好的算法。记忆提取的方式,还有强化学习的,在神经网络的内容是不一样。我今天讲了一个很重要的集群的概念,就是赫伯集群,这是嵌套式的,一群一群神经元代表不同的信息,然后捆绑在一起。捆绑的方式就是用同步的活动在大脑了有电活动捆绑集群。最后还有输入的图谱结构等等。

今天讲到这里,就是脑科学,和类脑智能有很多可以交换的地方,不光是脑科学为智能领域有影响,智能语义对脑科学的发展也有影响,这个细节我今天没有时间说了。所以我就讲到这里,谢谢大家。